Les Évaluations Du Kit Poppy ErgoJr

Les résultats de 2017-2018En 2018, nous avons collecté 242 réponses. 88 réponses concerne des utilisateur du kit robotique ErgoJr: 20 enseignants et 68 élèves dont 37 sont issus de section ISN, 12 de ICN, et 18 du collège. Il ont tous pratiqué des activités durant l’année scolaire 2016 — 2017 et ont répondu aux questionnaires à la fin de cette même année. Ces activités ont pu être plus ou moins longues, plus ou moins répétées ; pour déterminer ces paramètres un questionnaire de renseignements additionnels était intégré après les questionnaires d’utilisabilité, permettant de dégager 29 critères de discrimination visibles sur les figures. 154 réponses (dont 8 d’enseignants) ont servir à l’établissement d’une ligne de base pour les critère d’acceptabilité.

Le SUS « the Systeme Usability Scales »

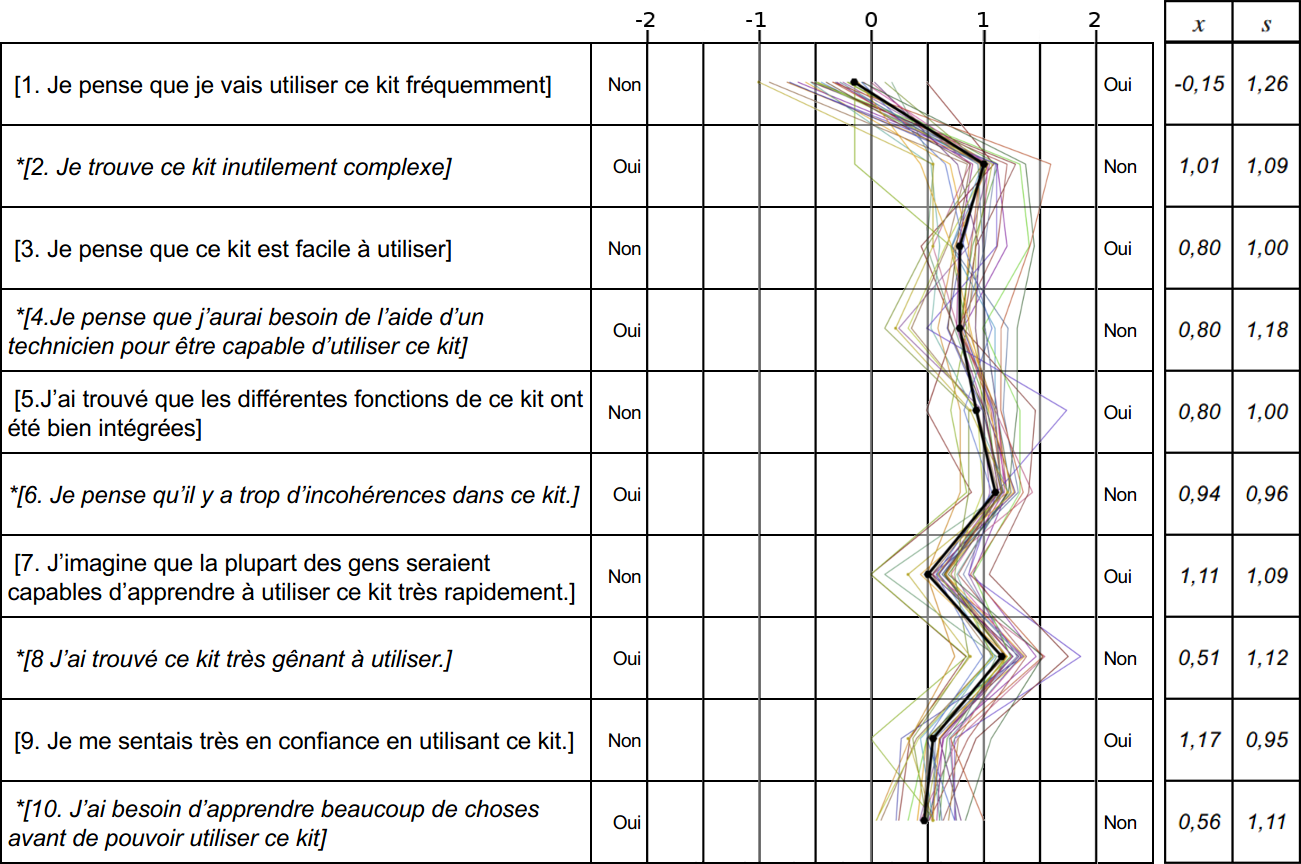

Il se compose d’une série de 10 affirmations à évaluer selon une échelle de Likert à 5 points. Le score obtenu varie entre -2 et 2 et permet de graduer l’utilisabilité définie sous la norme ISO 9241-11 par « le degré selon lequel un produit peut être utilisé, par des utilisateurs identifiés, pour atteindre des buts définis avec efficacité, efficience et satisfaction, dans un contexte d’utilisation spécifié ».

Nous pouvons observer sur la figure ci-dessous que la moyenne générale (axe noir en gras) est positive sur l’ensemble des affirmations hormis la première, cela est peut-être induit par l’environnement scolaire proposant des plannings stricts et de nombreux modules à explorer.

Les affirmations 4 et 8 offrent la plus grande variabilité suivant les modalités, l’affirmation 8 s’étale du « non » à « absolument non » montrant une bonne acceptance. L’affirmation 4 allant de « non » à « sans avis » associée aux affirmations 7, 3 et 10 (variant légèrement moins), évoquent les questions de prise en main et de capacité d’auto-formation, point que nous souhaitions optimiser.

Ici cette variabilité semble montrer que notre action a eu un impact mais pas sur l’ensemble de la population.

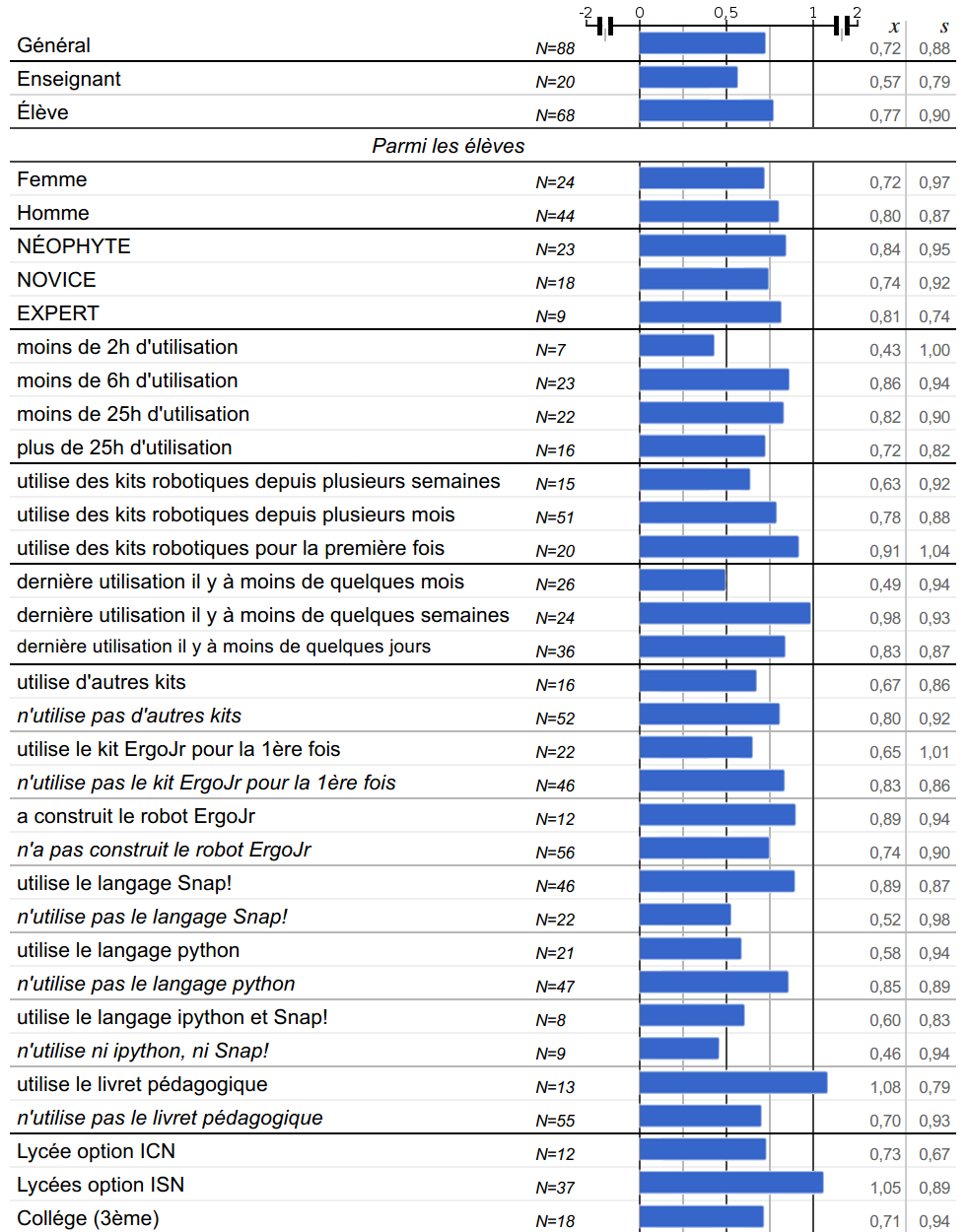

La rétrospective de 2013 du SUS nous apprend que le score moyen obtenu par des dispositifs au SUS est de 68/100 soit 0,72 sur l’intervalle [-2;2]. Dans notre étude, la moyenne générale a atteint 0,72: 0,57 pour les enseignants et 0,77 pour les élèves.

Lorsque nous observons les résultats avec plus de détails, nous pouvons nous apercevoir que certains usages font varier significativement le score du SUS de la moyenne, notamment:

un temps d’utilisation inférieur à 2 heures ou une longue période entre la dernière utilisation du kit et le passage du questionnaire qui l’impacte négativement ; l’utilisation du livret pédagogique qui l’impacte positivement ; le choix du langage de programmation Snap! ; python ; ou autre ayant un impact relatif au choix effectué: positif pour Snap!, négatif pour python ou les autres langages (non natif).

D’autre part, il est également intéressant d’observer les critères ne faisant pas varier significativement le score du SUS comme l’utilisation d’autres kits ou non ; la construction du robot ou non ; ou encore la distinction entre Enseignants/Élèves qui étaient des critères attendus comme discriminants. Cependant, concernant cette dernière, le faible effectif côté enseignants peut expliquer l’absence de différence significative. Enfin, nous n’observons pas de distinction Homme/Femme, comme il est courant de trouver dans d’autres disciplines.

Pour plus détails sur le SUS, vous pouvez consulter la publication s’y rapportant:

Thibault Desprez, Stéphanie Noirpoudre, Théo Segonds, Damien Caselli, Didier Roy, et al.. Poppy Ergo Jr : un kit robotique au coeur du dispositif Poppy Éducation. Didapro 7 2018 – DidaSTIC Colloque de didactique de l’informatique, Feb 2018, Lausanne, Suisse. pp.1-6. 〈hal-01753111v2〉

L’AttrakDiff

Il permettant d’évaluer l’expérience utilisateur suivant 4 échelles:

- Échelle de Qualité Pragmatique

- Échelle de Qualité Hédonique – Stimulation

- Échelle de Qualité Hédonique – Identité

- Échelle d’Attractivité globale

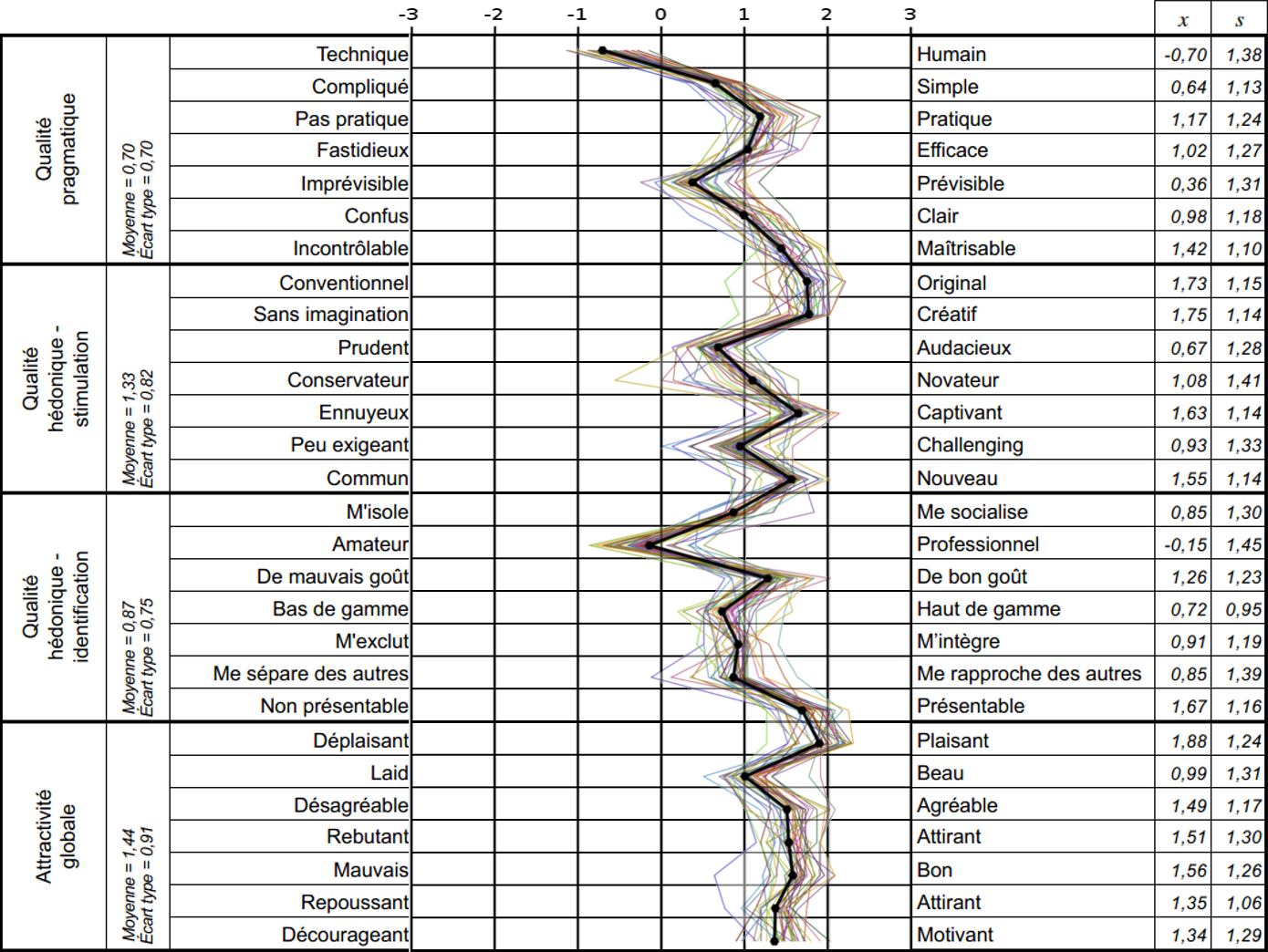

La première estime le niveau de difficulté perçu par l’utilisateur. La deuxième estime si le dispositif offre une expérience stimulante et novatrice pour l’utilisateur. La troisième estime l’intégration sociale perçue avec l’utilisation du dispositif. La quatrième estime les mêmes aspects mais d’un point de vue plus global. Pour obtenir ces scores, l’utilisateur est invité à noter 28 paires d’antonymes suivant une échelle à 7 points. Nous pouvons observer sur la figure~\ref{attrakdiff_chemin} le résultat pour nos 29 modalités pour les 28 paires de mots, ici ordonnées par catégorie.

Sur la figure ci-dessous nous pouvons voir qu’une majorité de réponses sont positives, et que plusieurs paires de mots semblent se distinguer, notamment: l’évaluation de Technique/Humain en moyenne à -0,70 et l’évaluation de Amateur/Professionnel à -0,15quand l’évaluation générale se situe à 1,20. Dans une moindre mesure nous observons la même distinction au niveau de Prévisible/Imprévisible 0,36 qui peut s’expliquer par la mise en avant dans les activités de la démarche d’apprentissage par essai-erreur. De la même façon on observe que les termes Original – Créatif – Plaisant obtiennent une meilleure évaluation que la moyenne, respectivement: 1,73 ; 1,75 ; 1,88.

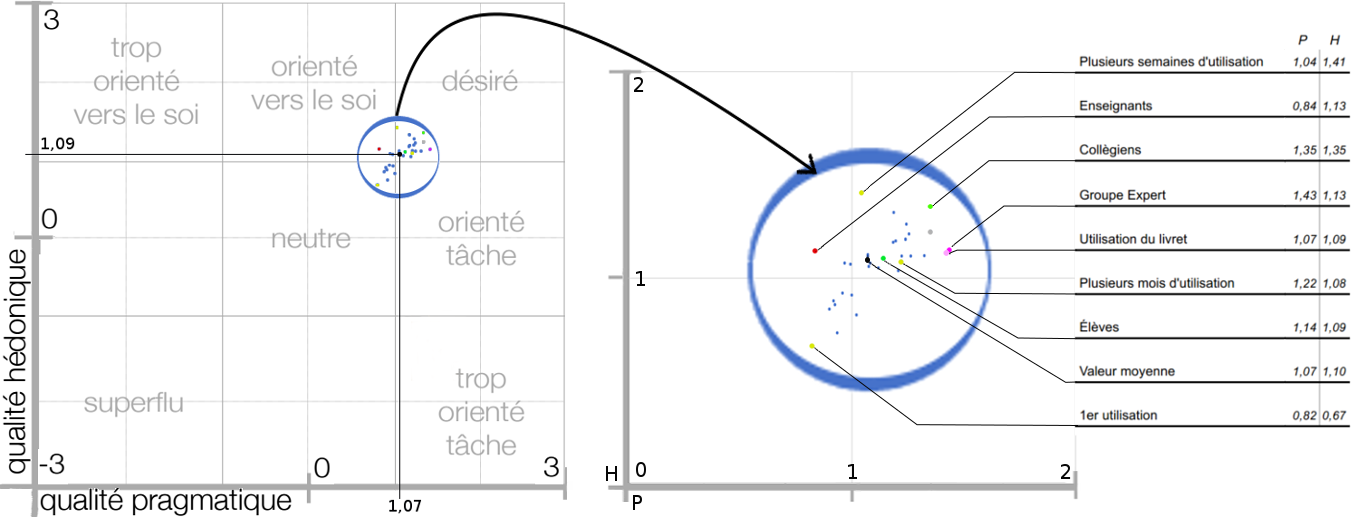

Au niveau des 4 échelles, nous observons que l’aspect stimulation 1,33 et l’attractivité globale 1,44 obtiennent de meilleurs résultats que l’aspect identification 0,87 et pragmatique 0,70. La moyenne de ces différentes échelles donne un score global de 1,087 pour l’ensemble de l’échantillon (N=88) ; de 1,057 pour les enseignants (N=20) ; et de 1,182 pour les élèves (N=68). Mais une représentation à deux dimensions nous permettra d’appréhender les résultats de manière plus efficiente. Ainsi nous pouvons observer, notamment sur la figure ci-dessous, que la répartition globale est plutôt bien localisée: la moyenne générale se situe à1,07 qui correspond à la valeur moyenne obtenue aux échelles « Qualité Pragmatique » et « Attractivité Globale »; et 1,09 qui correspond à la valeur moyenne obtenue aux échelles « Qualité Hédonique Stimulation » et « Identité ». En regardant par le prisme de nos 29 modalités, Nous observons que le nuage de points est plutôt homogène, mais certaines modalités obtiennent des valeurs plus extrêmes par rapport à notre échantillon de base.

Tout d’abord nous pouvons observer que le groupe d’enseignants s’écarte significativement du groupe des élèves, évaluant globalement la plateforme comme plus «orientée vers le soi » mais principalement causé par un score plus faible sur l’axe X noté P « qualité pragmatique » (sur l’axe Y noté H « qualité hédonique ». Ceci peut être induit par la stratégie de conception qui plaçait les besoins et envies de l’utilisateur au centre du développement.De plus l’enseignant adaptant le dispositif aux objectifs théoriques et pratiques qu’il s’est fixé, il semble cohérent que le score sur l’échelle pragmatique soit plus élevé chez les élèves, manipulant in-fine le dispositif modifié par l’enseignant pour les besoins de la tâche ou du TP. Ensuite nous pouvons remarquer que le temps total d’utilisation de la plateforme modifie les résultats. Ainsi, manipuler le kit pour la première fois provoque une moyenne des réponses significativement plus neutre, tandis que nous observons, pour le groupe l’ayant utilisé pendant plusieurs semaines, des valeurs significativement plus positives sur H ; le groupe pratiquant depuis plusieurs mois est lui beaucoup plus proche de la la moyenne mais reste significativement différent sur P et donc plus « orienté vers la tâche ». De plus cette proximité avec la moyenne pourrait s’expliquer par l’effectif important de cette sous-catégorie d’élèves. Un autre fait remarquable se situe au niveau de la modalité « utilise le livret pédagogique fourni » et le groupe « Expert » qui obtiennent une évaluation similaire sur les deux échelles et qui est significativement différente de la moyenne sur H et P pour la modalité « livret » mais uniquement sur P pour les « experts ». Enfin nous observons que le groupe des collégiens possède la meilleure évaluation globale, même si, individuellement ces moyennes sur les différentes échelles ne correspondent pas systématiquement à la valeur maximale.

Pour plus détails sur l’AttrakDiff, vous pouvez consulter la publication s’y rapportant:

Thibault Desprez, Stéphanie Noirpoudre, Théo Segonds, Damien Caselli, Didier Roy, et al.. Poppy Ergo Jr : un kit robotique au coeur du dispositif Poppy Éducation. Didapro 7 2018 – DidaSTIC Colloque de didactique de l’informatique, Feb 2018, Lausanne, Suisse. pp.1-6. 〈hal-01753111v2〉

Attitude Toward Robots (Euro382)

Plus de détails sur l’Euro382 dans la publication s’y rapportant, actuelle en cours de soumission.

0 commentaires